Azure AI FoundryでDeep Seek R1を試す

こんにちは!

KINTOテクノロジーズ(以下、KTC)の生成AI活用PJTで生成AIエバンジェリストをしている和田(@cognac_n)です。

Azure AI Foundryを用いてDeepSeek R1を試してみた

1. はじめに

最近、大規模言語モデル(LLM)の進化がめざましく、さまざまな企業が独自のLLMを発表しています。その中でも注目を集めているのが、中国のAI企業DeepSeekが開発したDeepSeek R1です。

2025年1月30日、MicrosoftはDeepSeek R1モデルをAzure AI FoundryとGitHubで提供開始しました。そこで本記事では、Azure AI Foundryを使ってDeepSeek R1を実際に試してみた際の流れや感想をまとめてみます。

2. Azure AI Foundryとは

Azure AI Foundryは、Microsoftが提供する包括的なAI開発プラットフォームです。開発者が生成AIソリューションやカスタムコパイロットを構築・評価・展開するためのツールとサービスを一元的に提供してくれます。

主な特徴

-

多様なAIモデルの活用:

MicrosoftやOpenAI、Hugging Face、Meta、Mistralなど、パートナー企業から提供される幅広い最先端モデル・オープンソースモデルをサポート。今回のDeepSeek R1もこの一環として提供されました。 -

統合されたAIツールチェーン:

開発ライフサイクル全体を加速させるためのSDKやAPI、ポータルが用意されており、データ前処理からモデル推論、継続的モニタリングまで一貫した体験が得られます。 -

責任あるAIの実践:

評価機能や安全フィルター、セキュリティ制御を組み込み、AIの信頼性と透明性を高める仕組みを提供します。 -

エンタープライズ向けのスケーラビリティ:

Azureのマネージドインフラ上で高い可用性と拡張性が確保されており、企業レベルのモニタリング・ガバナンスをサポートします。

Azure AI Foundry ポータルでモデル カタログを通じてモデルを使用する場合、プロンプトや出力がMicrosoftやモデル プロバイダーと共有されることはないと記載されており、様々なモデルをセキュアに利用することが可能です。

Microsoft では、ホスティング インフラストラクチャと API エンドポイントを提供および管理します。 この "サービスとしてのモデル" (MaaS) シナリオでホストされるモデルは、Azure のデータ、プライバシー、セキュリティのコミットメントの対象です。 Azure AI Foundry に適用できる Azure コンプライアンス認証の詳細を確認してください。

Microsoft は、従量課金制推論用にデプロイされたモデル (MaaS) により送信および生成されるプロンプトと出力のデータ プロセッサとして機能します。 Microsoft では、これらのプロンプトと出力をモデル プロバイダーと共有しません。 また、Microsoft は、Microsoft、モデル プロバイダー、またはサード パーティのモデルをトレーニングまたは改善するために、これらのプロンプトと出力を使用しません。

3. Azure AI Foundry上でのDeepSeek R1環境構築

ここからは、実際にDeepSeek R1をAzure AI Foundry上で利用するための手順を紹介します。なお、細かい画面遷移や設定項目については現時点(2025/1/31)の仕様となります。

UIや操作の変更が頻繁に行われるため、可能な限り公式ドキュメントを引用する形とします。

前提準備・アカウント設定

- Azureアカウントの用意

- Azure AI Foundryへのアクセス

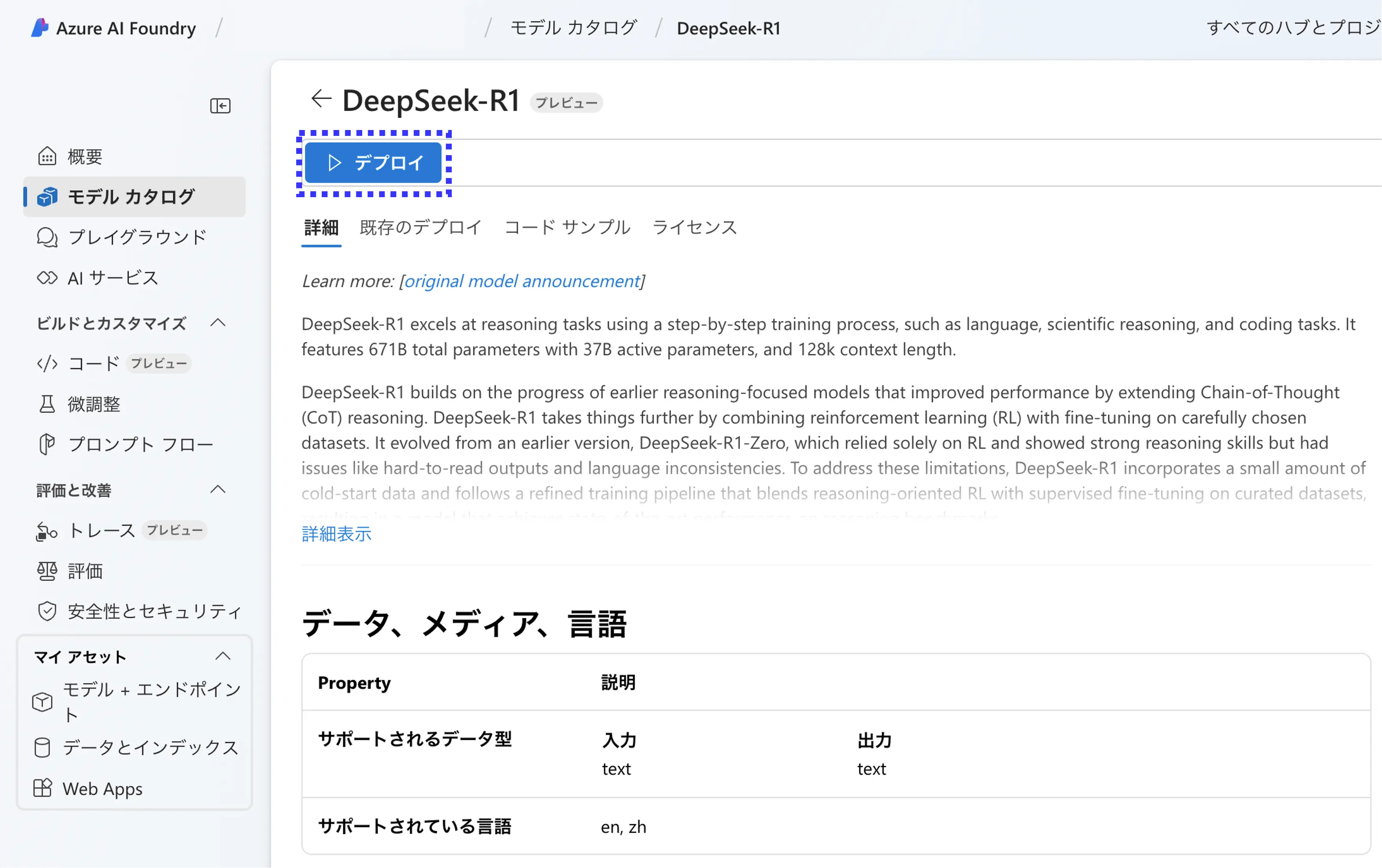

DeepSeek R1の導入手順

- プロジェクトの作成:

Azure AI Foundryポータル上で新規プロジェクトを作成します。DeepSeek-R1が使用可能なリージョンは[eastus2, westus3, northcentralus, eastus, southcentralus, westus]です。(2025/1/31時点)

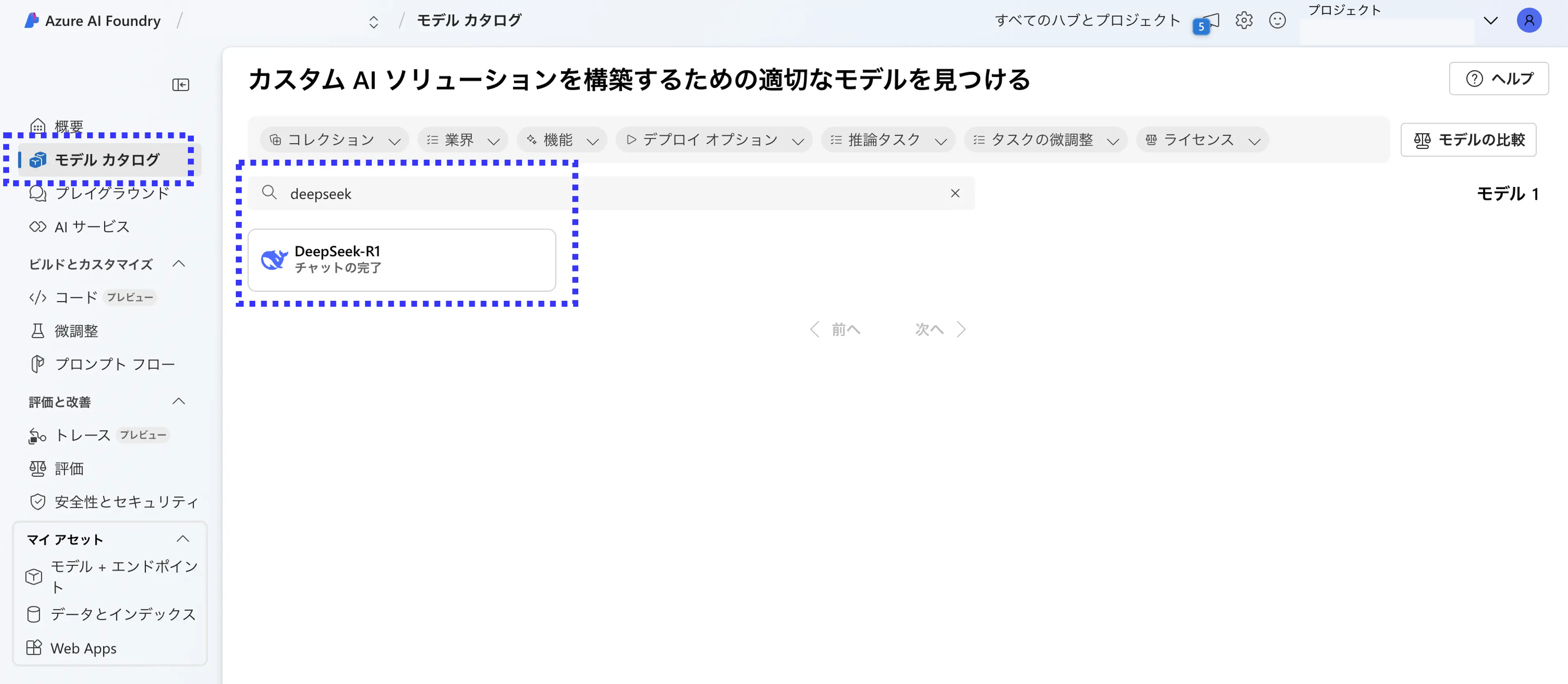

- DeepSeek R1モデルの選択:

「モデルカタログ」からDeepSeek R1を探し、モデルページに遷移します。

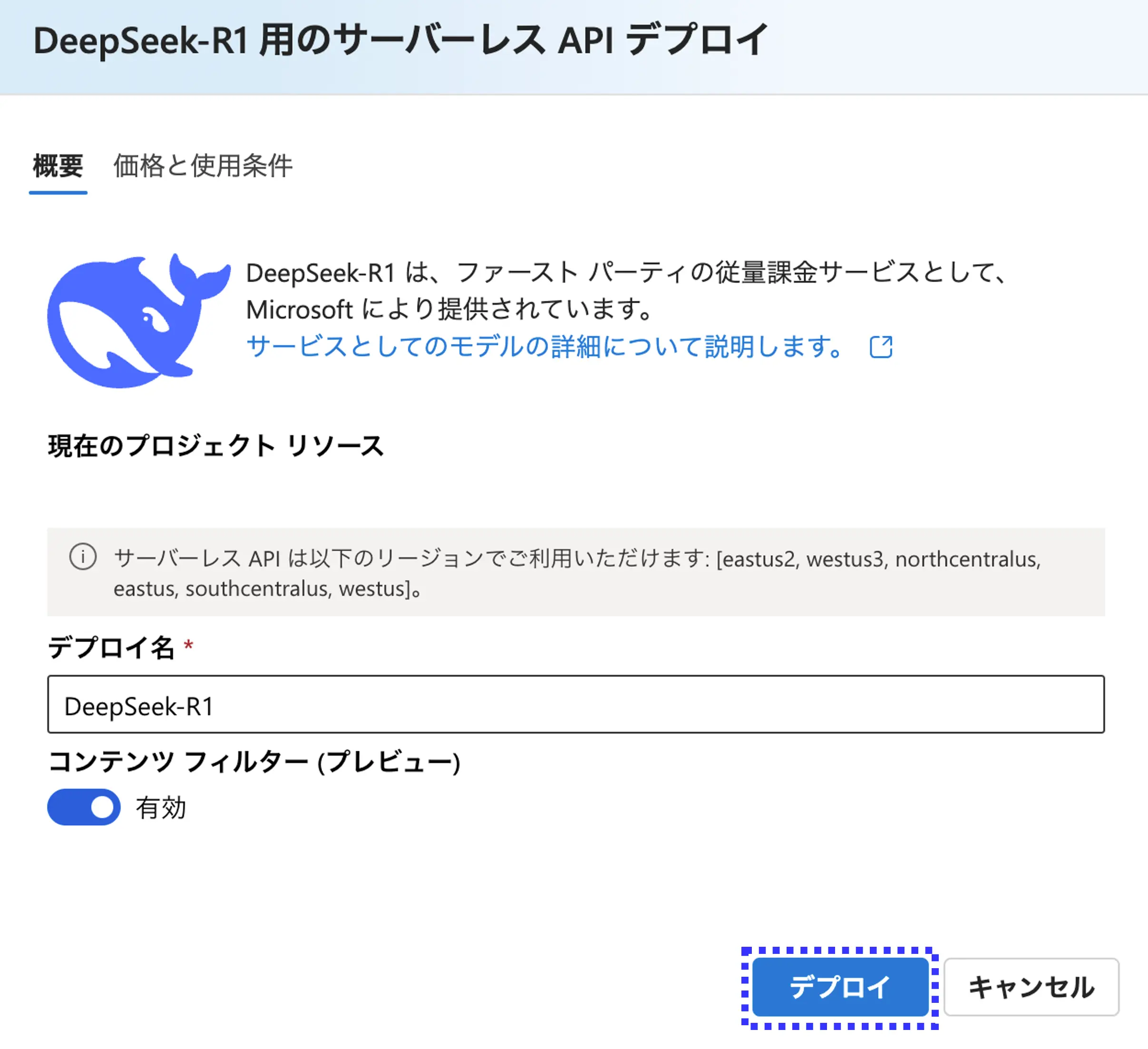

- デプロイ名の設定と価格の確認:

- 任意のデプロイ名を設定します

- コンテンツフィルターのON/OFFを設定します

- 2025/1/31時点で、DeepSeek-R1は無料提供されています。料金は今後変更されることが予想されるため、最新の情報を逐次チェックしましょう。

DeepSeek R1 use is currently priced at $0, and use is subject to rate limits which may change at any time. Pricing may change, and your continued use will be subject to the new price. The model is in preview; a new deployment may be required for continued use.

4. デプロイとエンドポイント構築:

Azure AI Foundryのワークスペース内で自動的にエンドポイントが生成され、モデルを呼び出すURIやAPIキーが発行されます。

4. DeepSeek R1を使った簡単なデモ

ここでは、実際にDeepSeek R1の推論を試すためのコード例を紹介します。

必要なライブラリをインストールします。

pip install azure-ai-inference

APIを利用するコードの例を以下に記載します。

Azure AI Foundryではコードサンプルも提供されるため、トライが非常に簡単です。

from azure.ai.inference import ChatCompletionsClient

from azure.ai.inference.models import SystemMessage, UserMessage

from azure.core.credentials import AzureKeyCredential

client = ChatCompletionsClient(

endpoint="<YOUR_TARGET_URI>",

credential=AzureKeyCredential("<YOUR_KEY>"),

)

deploy_name = "<YOUR_DEPLOY_NAME>"

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(

content="企業における生成AI利活用を推進する方法を考えてください。日本語で回答してください。"

),

],

max_tokens=2048,

model=deploy_name,

)

print(response.choices[0].message.content)

実際の応答例

<think>

まず、問題は何かを理解する必要があるね。企業が生成AIを使う推進方法について考えなきゃいけないんだ。

生成AIといってもいろんな用途があるから、まずは企業内での現状を把握しなきゃ。どの部門がAIを活用できそうか、どのような課題があるのかを調べる必要があるだろう。例えば、マーケティングや顧客サポート、業務自動化などが考えられるね。

次に、教育や研修が大事だと思う。従業員がAIの使い方を学べる機会を提供しないと、実際に活用するのは難しい。特に、AIに対する不安や理解不足を解消するため、ワークショップやトレーニングプログラムを実施した方がいいかも。

また、適切なツールの選定も必要。自社のニーズに合った生成AIのプラットフォームやツールを選ぶことが重要。場合によっては、カスタマイズが必要かもしれないし、セキュリティやデータプライバシーの問題にも対応しなきゃいけない。

管理層のサポートも不可欠だよね。経営陣が推進しないと予算やリソースが確保できない。AI導入のメリットを明確に伝えて、経営層の理解を得る必要がある。

さらに、成功事例を作ることが効果的。一部の部門で試験的に導入して成果を出せば、他の部門にも広がりやすい。結果を共有して、社内全体に広げていく戦略がいいかもしれない。

あと、倫理的なガイドラインやポリシーを整備することも重要。AIの誤用を防ぎ、責任ある活用を促すため、明確なルールを作る必要があるだろう。

継続的な評価と改善も忘れちゃいけない。導入後も効果を測定し、フィードバックを元に改善を重ねることで、持続的な推進が可能になる。

そういったポイントを整理して、具体的なステップを考えていく必要がありそうだな。

</think>

企業における生成AIの利活用を推進するためには、以下のステップを体系的に進めることが効果的です。

---

### **1. 現状分析と目標設定**

- **ニーズの特定**: 各部門(企画、営業、開発、サポートなど)の業務課題を洗い出し、生成AIが解決できる領域(ドキュメント作成、データ分析、顧客対応等)を明確化します。

- **優先順位付け**: 効果が高く実現可能性の高いユースケース(例:問い合わせ自動返信、報告書自動作成)から優先的に導入します。

---

### **2. 体制構築と意識改革**

- **推進チーム発足**: 経営層・IT部門・各部門の代表者が連携し、予算・リソースを確保します。

- **教育プログラムの実施**:

- **基礎理解**: 生成AIの仕組み・メリット・倫理リスク(情報漏洩、バイアス等)を研修で共有。

- **実践トレーニング**: プロンプト設計や出力検証の方法をハンズオン形式で習得させます。

---

### **3. ツール選定とテスト運用**

- **自社に適したAI選び**:

- オープンソース(Llama 2等)/クラウドサービス(ChatGPT Enterprise、Google Vertex AI等)を比較。

- セキュリティ基準(データ暗号化、学習済みモデルのカスタマイズ可否)を軸に選定します。

- **PoC(概念実証)**: 限定範囲でテスト運用し、精度・業務効率化効果を検証します。

---

### **4. ガバナンス整備**

- **利用ガイドライン策定**:

- 機密情報の入力禁止ルールや出力内容のダブルチェック体制を確立。

- 著作権・プライバシーに関する法的リスクに対応します。

- **モニタリング体制**: AIの出力品質や倫理面を定期的に監視し、改善を継続します。

---

### **5. 社内文化の醸成**

- **成功事例の共有**: 効果が出た部門のケースを社内発表やレポートで周知し、モチベーションを向上させます。

- **インセンティブ設計**: AI活用で業務効率化を達成したチームを表彰・報酬化します。

---

### **6. 外部連携と進化対応**

- **ベンダー・専門家との連携**: 最新技術動向の情報収集やカスタマイズ支援を受けます。

- **AIの継続的アップデート**: モデルの精度向上や規制変化に応じて活用方法を見直します。

---

### **ポイント**

- **経営層のコミットメント**: 投資対効果(ROI)の試算を示し、長期的な展望で支持を得ることが不可欠です。

- **現場主導の改善**: ユーザーである従業員のフィードバックを活用し、ツール改善やプロセス最適化を重ねます。

生成AIは「ツール」であり、活用の成否は「人間の使い方」に依存します。技術導入だけでなく、組織全体のデジタルリテラシー向上と心理的安全性の確保が鍵となります。

5. 実際に使ってみた感想・所感

-

レスポンス:

- 今回の回答には4分程度かかりました。LLM自体の推論にかかる時間と、利用が集中しているが故の処理時間の長さ、両方の影響がありそうです

-

出力精度:

- Thinkingを行う推論モデル故に抽象度が高かったり複雑度の高いプロンプトに対しても深い洞察を感じられる回答が返ってきます

- API利用では思考過程が<think>タグに囲まれた形式で出力されます。これは使いやすいですね

- <think>タグの中身を見ていくと、まるで複数人でディスカッションが行われたような思考過程を辿っています

-

まとめ:

- Azure AI Foundryを用いると、最新のサードパーティ製モデルを手軽に試すことが可能です

- 「まず試す」ことが重要な生成AI領域において、この手軽さは非常にありがたいですね

We Are Hiring!

KINTOテクノロジーズでは、事業における生成AIの活用を推進する仲間を探しています。まずは気軽にカジュアル面談からの対応も可能です。少しでも興味のある方は以下のリンク、またはXのDMなどからご連絡ください。お待ちしております!!

ここまでお読みいただき、ありがとうございました!

関連記事 | Related Posts

We are hiring!

生成AIエンジニア/AIファーストG/東京・名古屋・大阪・福岡

AIファーストGについて生成AIの活用を通じて、KINTO及びKINTOテクノロジーズへ事業貢献することをミッションに2024年1月に新設されたプロジェクトチームです。生成AI技術は生まれて日が浅く、その技術を業務活用する仕事には定説がありません。

【データサイエンティスト】データサイエンスG/東京・名古屋・大阪

データ分析部について※データ分析部は、データサイエンスGが所属している部門です。クルマのサブスクというビジネスモデルを展開するKINTOでは、市場やお客様のニーズを捉え、最高の顧客体験を提供するために、マーケティング分析においても挑戦と創造が求められます。

![Cover Image for [生成AI][Copilot] 非エンジニアの私がAIを使って運用ツールを開発した話](/assets/blog/authors/yamayuki/01.png)